Når og hvis du til høsten oppdaterer din iPhone, iPad, Apple Watch eller Mac til henholdsvis iOS 15, iPadOS 15, watchOS 8 eller macOS Monterey, så følger den helt nye funksjonen med. En funksjon som Apple har designet for å bekjempe barneporno og misbruk av barn. Dessverre ser det ut til at prisen for beskyttelsen av barna blir en avskjed med privatlivets fred.

Teknologien som Apple har utviklet, scanner så og si alt innholdet på Apple-enheten din for kjente barnepornobilder. Tilsvarende teknologi er for lengst blitt implementert hos tjenester som Gmail, Twitter, Facebook og Dropbox, men Apple har frem til nå avvist å ta i bruk lignende teknologi, fordi det ville undergrave end-to-end-krypteringen og beskyttelsen av brukernes data, som har vært et av Apples sentrale forretningsprinsipper.

Men som alle andre vil Apple naturligvis gjerne beskytte mindreårige mot misbruk og bekjempe utbredelsen av barneporno, og tech-giganten har derfor utviklet sin egen løsning, som ifølge Apple selv gjør det mulig å scanne etter ulovlig bildemateriale uten at det går på bekostning av brukerens sikkerhet.

Melding, Bilder og Siri

Apples initiativ består av tre separate funksjoner.

1) Bilder: Det amerikanske «National Center for Missing and Exploited Children» (NCMEC) opprettholder en database over kjerne barnepornobilder. Databasen inneholder en såkalt hashtabell, hvor hvert enkelt bilde har blitt tildelt en unik hashverdi som beregnes basert på data i det gjeldende bildet.

All eksisterende scannings-teknologier, herunder Microsofts PhotoDNA, fungerer ved at tjenesten scanner og analyserer bilder hos alle brukere. Et bilde som er identisk med et bilde i barnepornodatabasen består jo av identiske data og vil derfor også få samme hashverdi, og blir da en «hit» i databasens hashtabell.

Hvis man sender en e-mail med et vedlagt bilde til noen med Gmail eller laster opp et bilde på Facebook, så vil bildefilen alltid bli sendt gjennom et filter som kalkulerer bildets hashverdi og sammenligner det med databasen, for å sikre at det ikke er snakk om barneporno.

Men denne løsningen fungerer ikke hvis tjenesten bruker end-to-end-kryptering, for da er det ikke mulig å scanne innholdet. Og derfor har Apple valgt å implementere sitt scanne-system direkte på brukerens iPhone, iPad, Macbook, etc.

Hashtabellen fra NCMECs database blir med Apples neste oppgradering av sine operativsystemer simpelthen gjemt lokalt på brukerens enhet, og alle bilder som er oppbevart på enheten og/eller lastet opp til iCloud vil gå gjennom filteret.

På denne måten får ikke Apple direkte tilgang til brukerens filer, men hvert godkjent bilde tildeles en kryptert «safety voucher», og kun hvis et bestemt antall bilder (antallet er ukjent) har utløst en match i hashtabellen, og dermed blitt identifisert som barneporno, så kan Apple åpne opp for krypteringen og få tilgang til brukerens bilder.

Videre vil Apple selvfølgelig anmelde personen som er i besittelse av ulovlig bildemateriale til politiet.

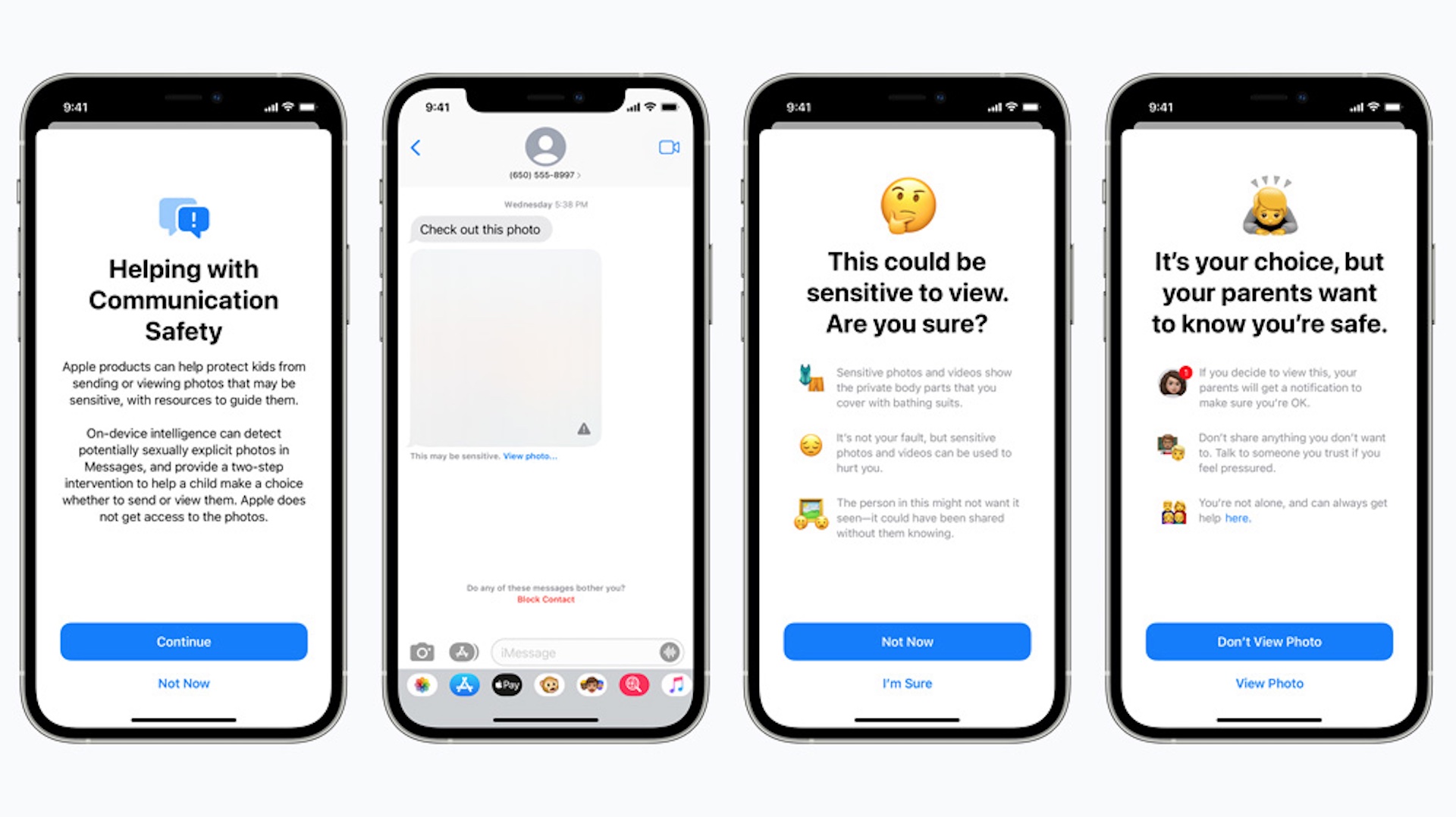

2) Meldinger: I tillegg til konstant overvåkning for å se etter kjent barnepornomateriale, så vil Apple også forhindre at mindreårige brukere sender eller mottar bilder med seksuelt innhold gjennom Apples end-to-end-krypterte meldings-app, iMessage.

Denne funksjonen vil i første omgang kun gjelde amerikanske brukere, men hensikten er ifølge Apple å gjøre beskyttelsen av barn mot seksuelt misbruk global.

Apple går ikke inn på detaljer om hvordan den nye funksjonen fungerer rent teknisk. Selskapet skriver bare i et white paper, at iMessage vil bli utvidet med machine learning – altså en kunstig intelligens – som opererer på brukerens enhet og analyserer alle vedlagte bildefiler for å se om de er av seksuell karakter eller ikke. Funksjonen blir kun aktivert for mindreårige brukere, da ut ifra alderen som er definert i iCloud Familiedeling.

Igjen har ikke Apple direkte tilgang til meldinger eller bilder, men dersom et vedlagt bilde blir kategorisert som frastøtende, så vil det bli sensurert, og foreldrene til den mindreårige vil få en melding hvis barnet deres er under 13.

3) Siri: Sist, men ikke minst, vil både Siri og Apple-enhetenes innebygde søkefunksjon bli endret, slik at søk etter ord som «barneporno» vil utløse en advarsel samt råd om hvor man kan søke hjelp.

FUCK Apple

FUCK dem 1.000 gange@infosecholsta jeg glæder mig til at se om du stadig kører Apple iPhone på BornHack 😛

— Henrik Kramselund Pfizer 2of2 🏳️🌈 (@kramse) August 6, 2021

Formålet er godt, men Apples avjørelse er en katastrofe

Apple har åpenbart anstrengt seg for å kunne utstyre enhetene sine med et høyt nivå av beskyttelse av barn uten å gå på kompromiss av enkeltbrukerens sikkerhet.

I motsetning til tidligere nevnte tjenester som Facebook, Google, Dropbox osv., som på ingen måte legger skjul på at de selvfølgelig har tilgang til alle dine data, har Apple alltid lagt stor vekt på at brukerens data ikke angår eller tilhører noe andre enn dem selv. Og hvert fall ikke Apple.

Og rent teknisk virker Apples løsning elegant, for selskapet får virkelig kun tilgang til dine bilder og data dersom det er treff i databasen over kjente barneporno-bilder, og i tilfeller med nakenbillder eller seksuelt eksplisitte bilder i meldinger hvor minst én deltaker er mindreårig, så er det kun barnets foreldre som får beskjed.

Men såvidt jeg har forstått er Apples nye tiltak i virkeligheten en katastrofe for privatlivets fred. Og det sier jeg ikke fordi jeg på noen måte ønsker å forhindre at barn beskyttes mot misbruk. Det sier jeg fordi Apples løsning på mange måter er et mye større inngrep enn løsningene som f.eks. Google, Facebook og Dropbox har tatt i bruk. Og dermed har Apple åpnet for en rekke muligheter for systematisk undergraving av datasikkerhet og brukerens rett til å bestemme hvem som har tilgang til deres data.

Apple plans to modify iPhones to constantly scan for contraband:

“It is an absolutely appalling idea, because it is going to lead to distributed bulk surveillance of our phones and laptops,” said Ross Anderson, professor of security engineering. https://t.co/rS92HR3pUZ

— Edward Snowden (@Snowden) August 5, 2021

«Slippery slope»

Det avgjørende her er at Apple med den nye teknologien i praksis har satt opp en lett tilgjengelig bakdør inn i alle brukernes fysiske enheter.

I og med at teknologien ikke bare konsentrerer seg om dataene du har valgt å sende til andre eller laste opp i skyen, men faktisk fungerer lokalt på din egen enhet, så har Apple i prinsippet skaffet seg tilgang til ALLE dine data. Alt du har liggende på mobilen, nettbrettet eller datamaskinen i hvert fall. Hvor som helst og når som helst.

Og selv om hensikten er svært god, så forhindrer det ikke et såkalt mission creep, hvor en teknologi som i første omgang blir implementert med en bestemt funksjon som alle støtter, med tiden kan bli misbrukt til andre formål.

Apples produkter selges over hele verden. Også i land som Kina, hvor Apple er under press fra den kinesiske regjeringen, og allerede har gått imot sine egne prinsipper og oppbevart følsomme kundedata fra kinesiske brukere på servere i et datasenter som er kontrollert av den kinesiske regjeringen. I tillegg til at Apple bl.a. også har fjernet VPN-apper fra App Store, fordi de kinesiske myndighetene har forlanget det.

Man trenger ikke stor fantasi for å forestille seg at teknologien som Apple nå integrerer i sine operativsystemer kan misbrukes av regjeringer, som f.eks. ønsker å lete etter brukere som har bilder av ulovlige politiske budskap på sine mobiler. Et svært realistisk scenario i f.eks. Hong Kong.

Et filter som leter etter seksuelt eksplisitte bilder av mindreårige, kan litt for enkelt justeres for å bli satt inn i jakten på homofile og transpersoner eller andre innenfor LGBT, i land hvor disse legningene og kjønnsidentitene er straffbare.

Og så videre, og så videre.

Hvis du ikke tror på at Apple noensinne vil tillate at deres teknologi blir misbrukt, så minner jeg igjen om hvordan Apple hjelper den kinesiske regjeringen med å uttøve sensor og gir de kinesiske myndighetene tilgang til data om politisk forfulgte kinesiske borgere.

Just to state: Apple’s scanning does not detect photos of child abuse. It detects a list of known banned images added to a database, which are initially child abuse imagery found circulating elsewhere. What images are added over time is arbitrary. It doesn’t know what a child is.

— SoS (@SwiftOnSecurity) August 5, 2021

Falsk markedsføring

At Apple selvfølgelig vil fortsatte med å markedsføre sine produkter og tjenester som end-to-end-krypterte, mens selskapet samtidig har integrert et sofistikert og effektivt overvåkningssystem i alle sine produkter, gjør meg ikke akkurat mindre frustrert.

Siden Apple på hyklerisk vis forsøker å skape tillit hos sine brukere, samtidig som de gjør det stikk motsatte av hva av de har sagt, ved å undergrave voldsomt ved å implementre overvåkningsprogramvare på systemnivå i enhetene til alle brukerne. Altså, stoler du virkelig så mye på Apple at du synes det er greit at mobilen eller dataen din blir utstyrt med teknolgi som kan analysere alle bildene dine?

Ikke engang en teknologi som er utviklet for å tjene en god sak kan rettferdiggjøre at brukernes rett ti privatliv blir undergravd.

1 hendelser på “Apples nye barneporno-filter går i fullstendig feil retning”

Legg igjen en kommentar

Les videre med LB+

Full tilgang 1 uke uten bindingstid!

Tilgang til ALT innhold i 1 UKE!

Tilbud - 4 uker 4,-

Tilgang til ALT LB+ innhold

LB+ total 12 måneder

Tilgang til ALT innhold i 12 måneder

- Tilgang til mer enn 7800 produkttester!

- Store rabatter hos våre samarbeidspartnere i LB+ Fordelsklubb

- Ukentlige nyhetsbrev med siste nytt

- L&B TechCast – en podcast av L&B

- Magsinet digitalt – ny utgave hver måned

- Deaktiver annonser

- L&B+ Video – bli med L&B redaksjonen behind the scenes, på de store tech-messene og mye mer!

Les videre med LB+

Full tilgang 1 uke uten bindingstid!

Tilgang til ALT innhold i 1 UKE!

Tilbud - 4 uker 4,-

Tilgang til ALT LB+ innhold

LB+ total 12 måneder

Tilgang til ALT innhold i 12 måneder

- Tilgang til mer enn 7800 produkttester!

- Store rabatter hos våre samarbeidspartnere i LB+ Fordelsklubb

- Ukentlige nyhetsbrev med siste nytt

- L&B TechCast – en podcast av L&B

- Magsinet digitalt – ny utgave hver måned

- Deaktiver annonser

- L&B+ Video – bli med L&B redaksjonen behind the scenes, på de store tech-messene og mye mer!

Altfor viktig kommentar til å bli skjult bak en betalingsmur!