Ifølge studien mislykkes såkalte «simulerte resonnementmodeller» som OpenAI:s o1 og o3, DeepSeek-R1 og Claude 3.7 Sonnet Thinking med problemer som krever systematisk tenkning. De produserer resultater som ikke er bedre enn om man bare leter etter tidligere svar på problemet i treningsdataene deres. Det er det tradisjonelle store språkmodeller gjør. Studien, som går under navnet «The illusion of thinking», kommer fram til et lignende resultat som en annen nylig publisert studie fra USA Mathematical Olympiad.

Forskerne undersøkte såkalte Large Reasoning Models, som forsøker å simulere en logisk resonerende prosess ved å bryte ned komplekse problemer til enklere og løse dem trinn for trinn.

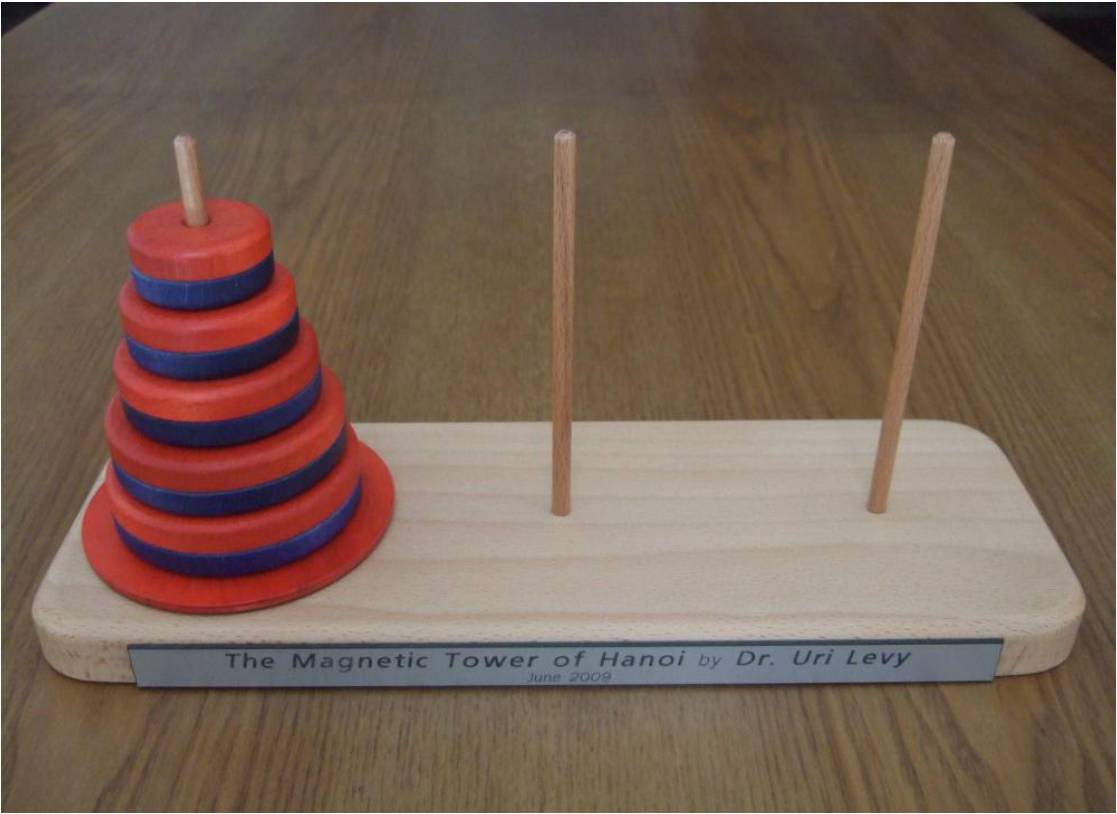

Undersøkelsen besto av å utsette AI-modellene for klassiske tankenøtter som Tower of Hanoi, spille Checkers (dam), tankenøtten med å krysse en elv og Blocks World. Man begynte på nybegynnernivå og økte vanskelighetsgraden til ekstremt vanskelig. For eksempel krever en 20-ringers Tower of Hanoi over en million trekk.

Resultatet var at de bare klarte å vise en løsning i under 5 prosent av tilfellene, og bare én klarte å nå 25 prosent. Ingen av dem klarte å vise en perfekt løsning til tross for 200 forsøk. Dette til tross for at KI-forskeren Herb Simon viste en løsning på Tower of Hanoi allerede i 1957, og det finnes mange ferdige algoritmer for løsningen på nettet. Ikke engang da forskerne utstyrte modellene med algoritmen, ble resultatet bedre. Noe som en forsker mente betydde at «prosessen deres ikke er logisk og intelligent».

Forskerne mener at problemet med dagens evalueringer av resonerende modeller er at de kun bryr seg om resultatet blir riktig. Om svaret fantes i treningsdataene deres er irrelevant, så ingen stiller spørsmål ved om de virkelig resonerer seg frem til svaret eller bare kopierer det.

Det skal sies at studien kommer fra Apples forskere, det eneste store teknologiselskapet som ikke har lansert en egen AI-løsning. Den har også fått kritikk da andre forskere påpeker at dagens modeller er bygget for å ikke bruke for mye tid på et problem. Hvis de ikke kan løse det raskt, gjetter de. Apples forskere sier også selv at «tankeøtter er et smalt område og kanskje ikke er representativt for problemløsning generelt», og advarer mot å ekstrapolere resultatet og trekke for vidtrekkende konklusjoner.

Når det er sagt, ble ChatGPT 4o slått av en Atari 2600 spillkonsoll fra 1977 når det gjaldt å spille sjakk…

Les studien hos Apple Research